I modelli di intelligenza artificiale sviluppati da OpenAI, Anthropic e altri importanti laboratori stanno rivoluzionando il modo in cui affrontiamo la programmazione. Il CEO di Google, Sundar Pichai, ha recentemente affermato che il 25% del nuovo codice dell’azienda è generato da AI, mentre il CEO di Meta, Mark Zuckerberg, sta promuovendo l’utilizzo degli strumenti di codifica AI all’interno del social media.

Tuttavia, anche i migliori modelli di intelligenza artificiale attuali faticano a risolvere problemi di debugging che non rappresenterebbero una sfida per gli sviluppatori esperti. Questo limite mette in luce le difficoltà che l’AI deve ancora superare per raggiungere la pari dignità con gli esseri umani in ambiti come la programmazione.

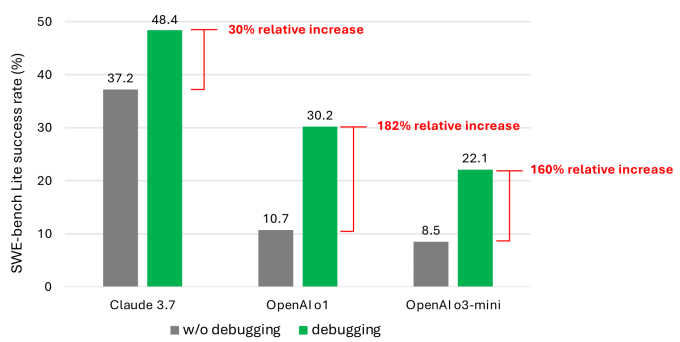

I risultati hanno mostrato che, anche con l’utilizzo dei modelli più recenti e potenti, l’agente raramente completava più della metà dei compiti di debugging con successo. Il modello con il tasso di successo medio più alto è stato Claude 3.7 Sonnet, con un risultato del 48,4%, seguito da OpenAI o1 con il 30,2% e o3-mini con il 22,1%. Questi dati mettono in evidenza le limitazioni attuali dell’AI nella risoluzione di problemi di debugging e sottolineano la necessità di ulteriori ricerche per migliorare le prestazioni dei modelli di intelligenza artificiale.

Microsoft AI debugging benchmark

I risultati delle prestazioni sono stati deludenti. Uno degli ostacoli principali è stato la difficoltà dei modelli nell’utilizzare gli strumenti di debug a loro disposizione e nel comprendere come diversi strumenti potessero aiutare a risolvere problemi specifici. Tuttavia, il problema più significativo è stato la carenza di dati. I co-autori ritengono che i dati attuali non rappresentino adeguatamente i “processi decisionali sequenziali”, ovvero le tracce di debug umane.

“Siamo convinti che il training o il fine-tuning dei modelli possa migliorare le loro capacità di debug interattivo,” affermano i co-autori nel loro studio. “Tuttavia, ciò richiederà dati specializzati per supportare l’addestramento di tali modelli, come ad esempio dati di traiettoria che registrano gli agenti che interagiscono con un debugger per raccogliere informazioni necessarie prima di suggerire una correzione di bug.”

I risultati non sono particolarmente sorprendenti. Numerosi studi hanno dimostrato che il codice generato dall’intelligenza artificiale tende a introdurre vulnerabilità di sicurezza ed errori a causa di debolezze in aree come la comprensione della logica di programmazione. Uno strumento di codifica AI molto popolare ha scoperto di poter completare solo tre test di programmazione su venti, mettendo in evidenza le limitazioni dell’AI nel debugging.

Il lavoro svolto da Microsoft rappresenta uno dei più approfonditi esami finora condotti su un’area di problema persistente per i modelli di intelligenza artificiale. Sebbene non sia probabile che questo studio riduca l’entusiasmo degli investitori per gli strumenti di codifica assistita da intelligenza artificiale, potrebbe almeno indurre gli sviluppatori e i loro superiori a riflettere due volte prima di affidare completamente all’intelligenza artificiale la gestione della codifica.

Va notato che un numero crescente di leader nel settore tecnologico ha sollevato dubbi sull’idea che l’intelligenza artificiale possa completamente automizzare i lavori di codifica. Bill Gates, co-fondatore di Microsoft, sostiene che l’intelligenza artificiale è qui per restare, ma non necessariamente per sostituire gli esseri umani. Anche altri importanti figure del settore, come il CEO di IBM Arvind Krishna, condividono questo punto di vista, sottolineando che l’intelligenza artificiale non sostituirà i programmatori nel prossimo futuro.