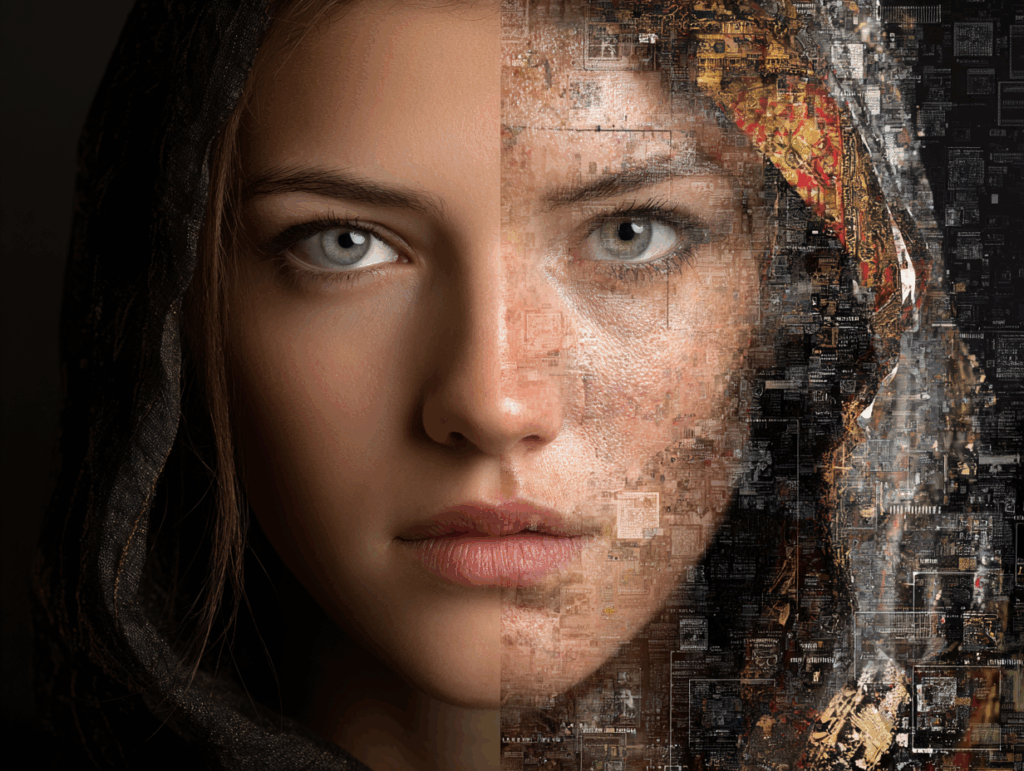

Immaginate di aprire il telefono e scoprire la vostra immagine, rubata da un vecchio post sui social, trasformata in un video porno senza il vostro consenso. Non è fantascienza: sta accadendo a centinaia di donne in Italia. “Mi sentivo violata, come se mi avessero strappato l’anima”, racconta Maria, una giovane insegnante di Milano che ha trovato una sua foto alterata su un sito adulto.

Ebbene, non è un caso isolato. Secondo un report di Amnesty International, il fenomeno delle immagini deepfake e doctored sta esplodendo, con l’Italia al centro di una vera e propria emergenza etica. Queste donne non stanno più in silenzio. Hanno deciso di agire, unendo forze con avvocati e attiviste per sfidare i giganti del porno online.

Pensateci: in un mondo dove l’AI rende tutto possibile con un click, la linea tra realtà e finzione si dissolve. Ma chi protegge le vittime? La domanda retorica che sorge spontanea è: quanto vale la nostra privacy in era digitale? Queste storie non sono solo personali; sono un campanello d’allarme per tutti noi.

Indice

Il grido di chi si sente invasa

Queste donne non stanno più in silenzio. Hanno deciso di agire, unendo forze con avvocati e attiviste per sfidare i giganti del porno online. Pensateci: in un mondo dove l’AI rende tutto possibile con un click, la linea tra realtà e finzione si dissolve.

Ma chi protegge le vittime? La domanda retorica che sorge spontanea è: quanto vale la nostra privacy in era digitale? Queste storie non sono solo personali; sono un campanello d’allarme per tutti noi.

La tecnologia che alimenta l’incubo

Al cuore di questo abuso c’è la tecnologia, spesso deepfake generati da tool AI accessibili a chiunque. Prendete FaceSwap o app simili: bastano pochi minuti per sovrapporre un volto a un corpo in un video esplicito. Wow, è sconcertante quanto sia semplice.

Siti di pornografia online ospitano contenuti del genere, caricati da utenti anonimi che sfruttano foto da Instagram o Facebook. Non si tratta solo di editing basilare; l’intelligenza artificiale, con modelli come Stable Diffusion, crea video iper-realistici che ingannano anche l’occhio esperto.

Ma andiamo più a fondo. Questi tool usano algoritmi di machine learning per analizzare tratti facciali e mapparli su scene adulte. Il risultato? Immagini che sembrano autentiche, ma che distruggono vite.

Una ricerca dell’Università di Bologna evidenzia come il 96% dei deepfake online sia pornografico e non consensuale, con le donne come principali bersagli. E qui entra il paradosso: la stessa tecnologia che promette innovazione – pensate alle AI Lens di Snapchat per filtri creativi – diventa arma di violenza. Davvero, ci fa riflettere su chi controlla questi poteri.

Le conseguenze psicologiche sono devastanti. Ansia, depressione, perdita di fiducia: Maria, ad esempio, ha smesso di postare foto online per mesi. Eppure, c’è un barlume di speranza. Esperte come la ricercatrice AI Sofia Rossi sottolineano che watermark digitali e blockchain potrebbero tracciare queste manipolazioni, rendendole più facili da identificare.

La ribellione legale: da Milano a Bruxelles

Le donne italiane non aspettano soluzioni dall’alto; stanno portando la lotta nei tribunali. Prendete il caso di Elena, una designer romana che ha citato in giudizio un sito porno francese per diffamazione e violazione della privacy.

Grazie al GDPR, l’Europa offre armi potenti: multe fino al 4% del fatturato globale per chi non protegge i dati. In Italia, la Procura di Milano ha aperto indagini su piattaforme che ignorano le rimozioni richieste, applicando la legge sul revenge porn del 2013, estesa ora ai deepfake.

E non è solo azione individuale. Associazioni come Donne in Rete hanno raccolto oltre 200 testimonianze, spingendo per una normativa specifica. Immaginate: una legge che obblighi i siti a usare AI per rilevare contenuti falsi, simile al Digital Services Act UE.

“È ora di smettere di colpevolizzare le vittime”, dice l’avvocata Laura Bianchi, che rappresenta diverse donne in cause collettive. Queste battaglie stanno facendo rumore: Pornhub ha già rimosso migliaia di video su segnalazione, ma è abbastanza? La domanda è aperta, e le attiviste spingono per server localizzati in Europa, per aggirare giurisdizioni permissive come quelle USA.

Intanto, a livello internazionale, casi simili in UK e USA ispirano. Lì, leggi come la DEEP FAKES Accountability Act impongono etichette sui contenuti sintetici. In Italia, potremmo vedere presto qualcosa di simile, grazie alla pressione dal basso.

Un cammino verso la protezione digitale

Guardando avanti, questa lotta delle donne italiane non è solo contro i siti porno, ma per ridisegnare il web. Educare all’uso responsabile dell’AI è cruciale: scuole e aziende devono insegnare i rischi dei deepfake fin da giovani.

Pensate a campagne come quelle di #MyImageMyChoice, che incoraggiano le donne a controllare le proprie foto con tool di privacy. Eppure, resta l’incertezza. Con l’AI che evolve – basti pensare a modelli come Midjourney che generano immagini da testo – come stare al passo?

Le storie di Maria ed Elena ci ricordano che la tecnologia è neutra, ma l’uso no. Serve un’alleanza tra vittime, tech e legislatori per un internet più sicuro. Alla fine, non è solo una questione di rimozione: è di restituzione potere alle persone.