In occasione della sua conferenza Cloud Next, Google ha svelato la nuova generazione del suo potente chip di accelerazione AI, noto come TPU. Questa innovativa tecnologia rappresenta un importante passo avanti nel campo dell’intelligenza artificiale.

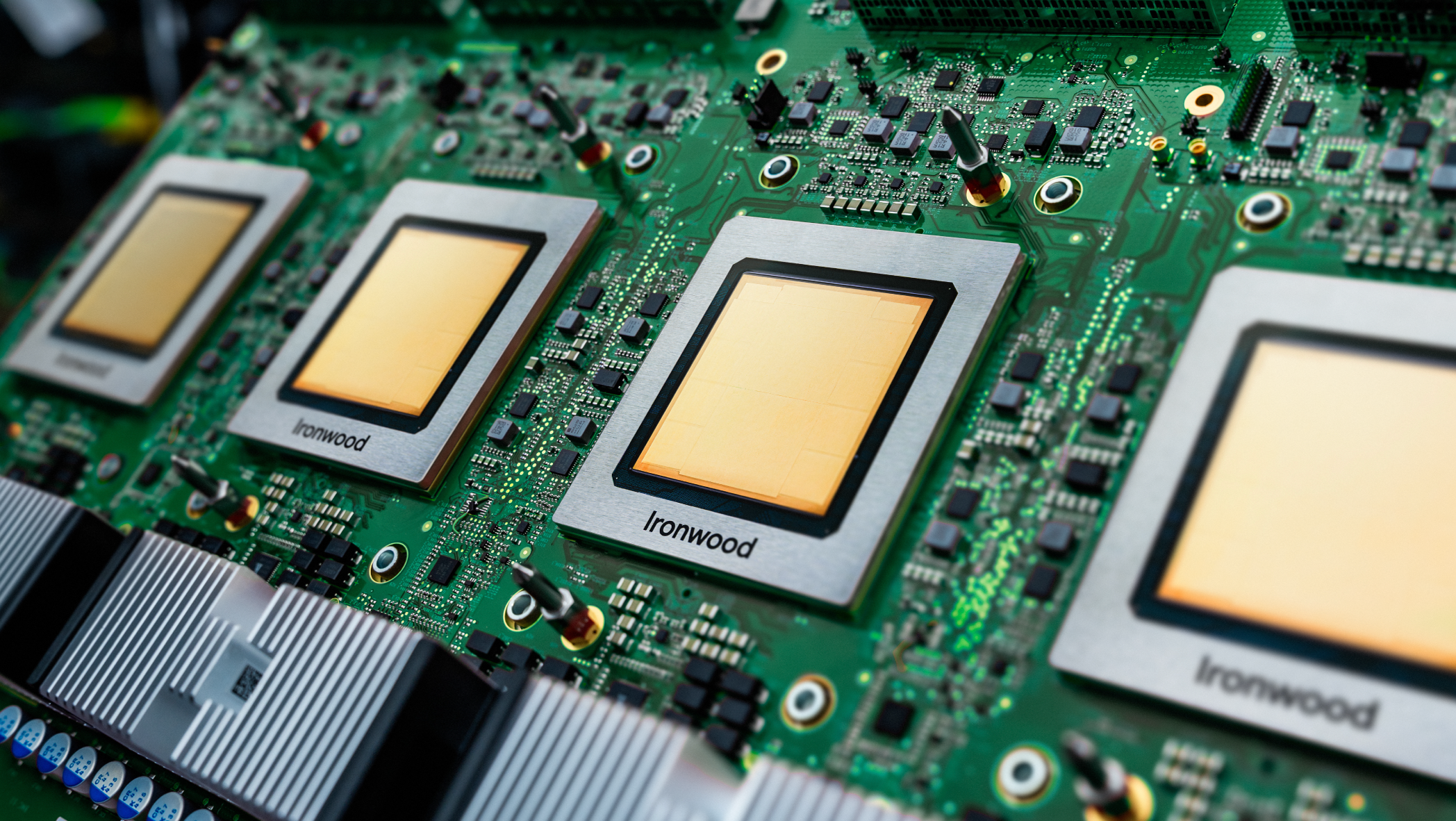

Il chip Ironwood, settimo nella serie di acceleratori AI di Google, è stato progettato specificamente per ottimizzare le prestazioni di inferenza, ovvero l’esecuzione di modelli AI. Sarà disponibile per i clienti di Google Cloud entro la fine dell’anno e verrà offerto in due diverse configurazioni: un cluster di 256 chip e un cluster di 9.216 chip. Questa flessibilità permetterà di adattarsi alle esigenze specifiche di ciascun utente.

Amin Vahdat, vicepresidente di Google Cloud, ha sottolineato le caratteristiche eccezionali di Ironwood, definendolo “il nostro chip di accelerazione AI più potente, capace ed efficiente in termini di energia”. Il chip è stato progettato per supportare modelli AI di pensiero e inferenza a larga scala, consentendo così di affrontare sfide complesse con maggiore facilità.

L’introduzione di Ironwood si inserisce in un contesto di crescente concorrenza nel mercato degli acceleratori AI. Sebbene Nvidia sia attualmente il leader di mercato, altri giganti della tecnologia, come Amazon e Microsoft, stanno sviluppando le loro soluzioni interne. Ad esempio, Amazon offre i suoi Trainium, Inferentia e Graviton attraverso il suo servizio cloud AWS, mentre Microsoft ha sviluppato il chip AI Maia 100 per le istanze Azure. In questo scenario, Ironwood rappresenta un’importante mossa strategica per Google.

Crediti immagine: Google

Il processo di Ironwood può raggiungere una potenza di calcolo impressionante di 4.614 TFLOPs al picco, come dimostrato dai test interni di Google. Inoltre, ogni chip dispone di 192 GB di RAM dedicata, con una larghezza di banda che raggiunge i 7,4 Tbps.

Ironwood presenta un nucleo specializzato avanzato chiamato SparseCore, progettato specificamente per l’elaborazione dei tipi di dati più comuni nei carichi di lavoro di classificazione avanzata e raccomandazione. Ad esempio, un algoritmo che suggerisce abbigliamento in base alle tue preferenze. L’architettura del TPU di Google è stata ottimizzata per ridurre al minimo il movimento dei dati e la latenza sulla scheda, portando a risparmi di energia.

Google prevede di integrare Ironwood con il suo AI Hypercomputer, un cluster di calcolo modulare in Google Cloud, nel prossimo futuro. Questa integrazione dovrebbe portare a nuove possibilità di calcolo e analisi dei dati.

Secondo Vahdat, “Ironwood rappresenta un punto di svolta unico nell’era dell’inference, con una potenza di calcolo aumentata, capacità di memoria avanzate e miglioramenti nella rete e nell’affidabilità”.

Inoltre, è importante notare che Ironwood non è l’unico chip AI sul mercato. Altri player, come Microsoft, stanno lavorando sui propri chip AI, come il Maia 100. Tuttavia, Ironwood sembra essere un passo avanti significativo nel campo dell’elaborazione dei dati e dell’intelligenza artificiale.